Entropie

chaos | entropie | generátor | hash | mmBIP32-84 | adresy | transakce | blockchain | halving |

Entropie je míra „neuspořádanosti“ – respektive míra nejistoty nebo náhodnosti v sadě dat. Pro představu se jedná o měřítko toho, jak moc jsou data nepředvídatelná. V kontextu generovaných náhodných čísel nám entropie říká, jak (ne)rovnoměrně jsou ta čísla rozložena.

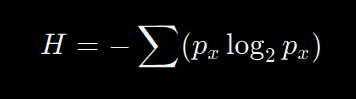

Informační nebo též shannonovská entropie je střední hodnota množství informace připadající na jeden symbol generovaný stochastickým zdrojem dat.

https://cs.wikipedia.org/…_entropie (wiki.cz)

Jak funguje vzorec pro výpočet entropie?

Vzorec pro výpočet entropie, který používáme, je známý jako Shannonova entropie. Představ si, že máš řadu čísel a chceš zjistit, jak moc jsou tato čísla náhodná. Postupujeme podle následujících kroků:

- Spočítáme frekvenci každého čísla:

- Nejprve zjistíme, kolikrát se každé číslo v sadě objevuje. Například, pokud máš čísla [1, 2, 2, 3, 3, 3], číslo 1 se objevuje jednou, číslo 2 dvakrát a číslo 3 třikrát.

- Vypočítáme pravděpodobnost každého čísla:

- Pravděpodobnost je frekvence čísla vydělená celkovým počtem čísel. Pokud máme 6 čísel, pak pravděpodobnost, že se objeví číslo 1, je 1/6, číslo 2 je 2/6 a číslo 3 je 3/6.

- Použijeme Shannonův vzorec pro výpočet míry entropie:

- px je pravděpodobnost každého čísla.

- součin nám říká, jak moc každé číslo přispívá k celkové entropii.

- Sečteme všechny tyto hodnoty a vynásobíme je -1 (protože log2px\log_2 p_xlog2px je záporné číslo).

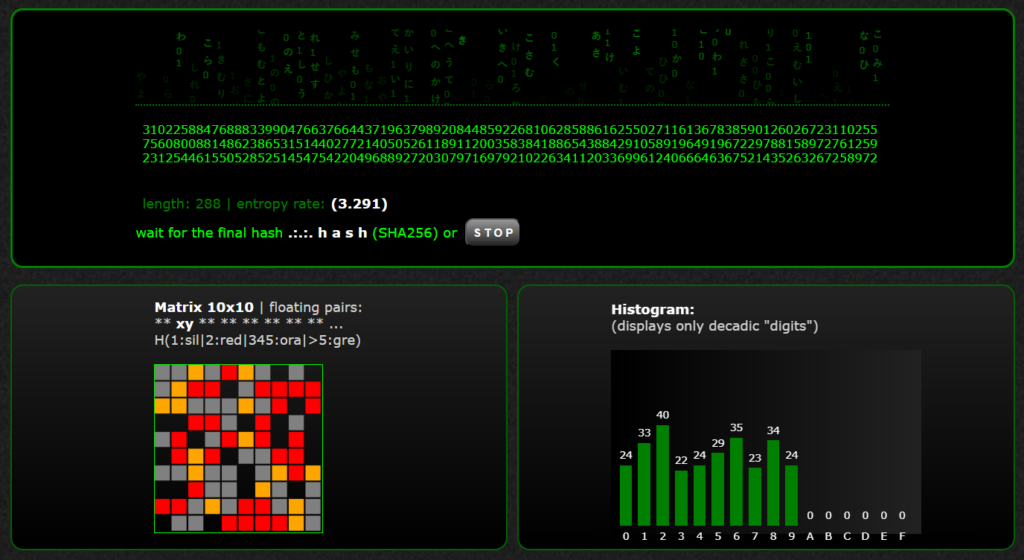

https://www.agamapoint.com/bitcoin/entropy_matrix.html

Generátor entropie >

Příklad:

Představ si, že máš čtyři čísla [1, 1, 2, 3]:

- Frekvence:

- Číslo 1: 2krát

- Číslo 2: 1krát

- Číslo 3: 1krát

- Pravděpodobnosti:

- p1=2/4=0.5p_1 = 2/4 = 0.5p1=2/4=0.5

- p2=1/4=0.25p_2 = 1/4 = 0.25p2=1/4=0.25

- p3=1/4=0.25p_3 = 1/4 = 0.25p3=1/4=0.25

- Vzorec pro entropii:H=−(0.5log20.5+0.25log20.25+0.25log20.25)H = – (0.5 \log_2 0.5 + 0.25 \log_2 0.25 + 0.25 \log_2 0.25)H=−(0.5log20.5+0.25log20.25+0.25log20.25)

- log20.5=−1\log_2 0.5 = -1log20.5=−1

- log20.25=−2\log_2 0.25 = -2log20.25=−2

Takže entropie této sady čísel je 1.5. Vyšší hodnota entropie znamená větší náhodnost nebo nejistotu v datech.

Co nám entropie určuje?

- Nízká entropie: Znamená, že data jsou více předvídatelná. Například, pokud máš [1, 1, 1, 1], entropie bude velmi nízká, protože všechna čísla jsou stejná.

- Vysoká entropie: Znamená, že data jsou méně předvídatelná. Například, pokud máš [1, 2, 3, 4], entropie bude vyšší, protože všechna čísla jsou různá a rovnoměrně rozložena.

Doufám, že to takto dává smysl! Entropie nám tedy pomáhá pochopit, jak moc náhodná nebo nepředvídatelná jsou naše data.